Wielokrotnie słyszałem, że „dawniej było wiadomo, że jak zapowiadali deszcz, to padało, a dzisiaj to nic się nie sprawdza”. Czyżby? A co takiego się nie sprawdza? „Nic się nie sprawdza. Zapowiadają deszcz, a świeci słońce.”

PRZECZYTAJ TAKŻE “MeteoZwierzenia”: 80 węzłów na Morzu Śródziemnym?

No to zacznijmy od początku. Czego potrzebujemy do sporządzenia prognozy? „GRIBów!” No tak, ale co to są te tajemnicze GRIBy?

GRIB (GRIded Binary) to nic innego, jak format do przechowywania danych. Te dane to wyniki obliczeń matematycznych modeli pogodowych. Ilość tych danych jest gigantyczna. IBM oszacował, że obecnie produkujemy 2,5 kwintyliona bajtów danych z modeli na dobę (jeden kwintylion to jedynka i 30 zer!). To tak, jakby wszystkie zasoby Biblioteki Kongresu Amerykańskiego przerobić na wersję cyfrową i przemnożyć przez trzy. I to by było na sekundę!

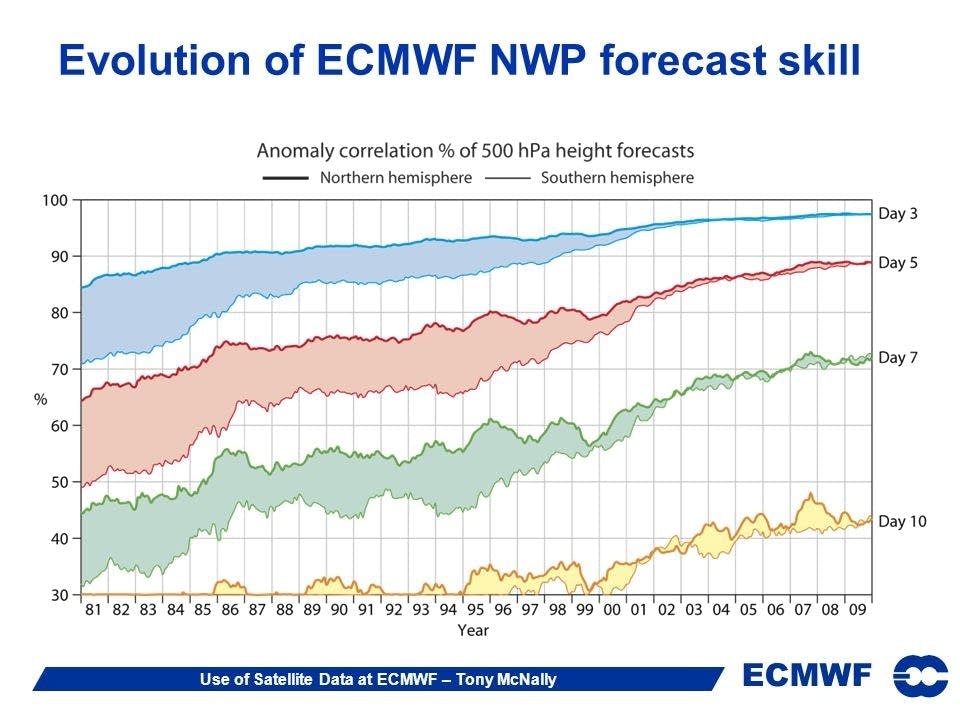

Na tym etapie i przy takiej ilości danych jakakolwiek ingerencja człowieka nie jest możliwa. Jak więc radzą sobie z pogodą komputery? Całkiem dobrze. Nawet można powiedzieć, że coraz lepiej. Trzydniowa prognoza pogody w roku 1980 miała sprawdzalność około 80 proc. W roku 2010 wzrosła ona do niemal 98 proc.

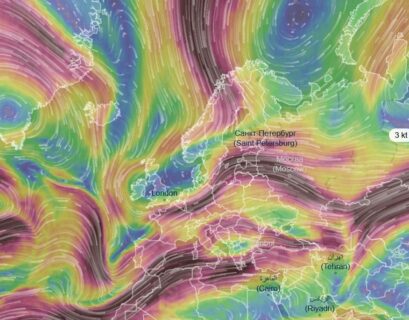

Na załączonym rysunku przedstawiona jest procentowa korelacja prognozy wysokości izobary 500 hPa, czyli około 5,5 km nad powierzchnią Ziemi, przedstawiona w funkcji czasu. Odnosi się to do europejskiego modelu ECMWF (European Centre for Medium-Range Weather Forecasts) i pokazane są prognozy 3-, 5-, 7- i 10-dniowe.

W pierwszej połowie wykresu wyraźnie widać różnice sprawdzalności prognoz pomiędzy północną i południową półkulą – górne i dolne ograniczenie każdej z prognoz. Ta grafika powoli się zawęża, by od mniej więcej roku 2000 przejść w niemal jedną linię. Skąd ta różnica? Każdy model musi mieć do obliczeń dane wyjściowe, czyli aktualny stan pogody.

Stan pogody bierze się z … pomiarów. Wszystkie państwa utrzymują sieć stacji pomiarowych, ale są to stacje w większości wypadków na lądzie. Jest też cała flota statków, które dobrowolnie wysyłają informacje pogodowe. To statki handlowe trzymające się utartych szlaków.

A teraz spójrzmy na globus. Nie na płaską mapę, a na globus, bo Ziemia jest, wbrew niektórym głosom, okrągła. Od razu rzuca się w oczy, że na południowej półkuli jest mniej lądów, a za to więcej oceanów. Niestety, większa ilość wody nie przekłada się tu na więcej szlaków żeglugowych, które leżą w większości na półkuli północnej.

Właśnie doszliśmy do odpowiedzi na pytanie, skąd ta różnica w jakości prognoz pomiędzy półkulami – na południu jest dużo mniej stacji pomiarowych. Dlaczego zatem w XXI wieku tych różnic już nie ma? Tu kłania się technika satelitarna. Pod koniec XX wieku analiza danych zbieranych dzięki satelitom doszła do wyników, dzięki którym można z nich bezpośrednio odczytać parametry, które wcześniej można było uzyskać tylko przez pomiary na miejscu.

Poza danymi satelitarnymi olbrzymi wkład w poprawienie jakości prognoz pogody ma stale zwiększająca się moc obliczeniowa komputerów. Dzięki temu modele nie tylko są szybciej liczone. Przede wszystkim można zagęścić tak zwaną siatkę. Model liczy poszczególne parametry tylko w określonych punktach globusa. Czym więcej tych punktów, tym więcej mocy obliczeniowej potrzeba, ale też tym dokładniejsza jest prognoza.

To widać choćby na wykresie przedstawiającym średni błąd przewidywanej temperatury. Wprawdzie jest ona tu podana w stopniach Fehrenheita, ale chodzi przecież o wielkości relatywne, więc nie ma to aż takiego znaczenia. Zresztą Fahrenheit był gdańszczaninem, wiec choćby dlatego zasługuje, żeby go tu zostawić. Widać, że błąd zmniejszył się w latach 1972 do 2017 o połowę. Błąd prognozy 3-dniowej w 1972 roku był taki, jak obecnie błąd prognozy 7-dniowej.

Źródło: Weather Prediction Center, NOAA (NOAA Freedom Of Information Act.)

Podsumowując część automatyczną powstawania prognoz, do polepszenia ich sprawdzalności przyczyniły się pomiary satelitarne i zwiększenie mocy obliczeniowej komputerów. To nie koniec ulepszeń, ponieważ teraz wkracza człowiek i jego doświadczenie w przewidywaniu pogody lokalnie.

Najlepszą weryfikacje sprawdzalności prognoz mielibyśmy, stawiając stację pomiarową w miejscu punktu węzłowego siatki modelu. Właśnie dla tego punktu model liczy prognozę. Jeżeli ma padać, to będzie padało w tym miejscu. Siatka najbardziej popularnego, amerykańskiego modelu GFS (Global Forecast System) ma bok o długości ¼ stopnia, czyli 15 mil morskich. Chmura, z której pada deszcz może być podobnych rozmiarów, ale może też być mniejsza.

Przewidywanie parametrów ciągłych, takich jak temperatura czy ciśnienie powietrza jest dla modelu dużo łatwiejsze, niż wyliczenie obecności chmur czy opadów. Używane są do tego dość skomplikowane parametryzacje, ale i tak największym problemem jest wielkość siatki i jej rozmiary zbliżone do wielkości chmury. Tu właśnie wkracza człowiek i jego lokalne doświadczenie. To właśnie dyżurny synoptyk znający lokalne uwarunkowania wie, w którym miejscu i kiedy można ufać modelowi, a gdzie, kiedy i jak bardzo należy w jego wyniki ingerować.

Nie śmiejmy się. Na wykresie widać, że niezależnie od jakości modelu, bo na osi czasu są lata od 1992 do 2017, „poprawki ludzkie” zwiększają trafność prognozy 30 do 40 proc. Akurat ten wykres dotyczy opadów, a to jak już wspomniałem, najtrudniejszy dla modeli parametr do obliczeń.

Na zakończenie przyjrzyjmy się „naszym” prognozom. Tym, co to „nigdy się nie sprawdzają”. Skąd je bierzemy? Kto je produkuje? W 99,9 proc. są to obrobione maszynowo wyniki modelu. Najczęściej modelu GFS, choćby dlatego, że dostęp do niego jest bezpłatny. Oczywiście trzeba spełnić pewne warunki, ale formalnie rzecz biorąc każdy może sobie te dane ściągnąć z serwerów NOAA i przerobić na własną modłę. Już z tego faktu wynika, że możemy się spodziewać 30 – 40 proc. nieścisłości w przypadku opadów.

Gdzie jeszcze spotykamy się z prognozami, w które ingerował synoptyk? W telewizji albo w serwisie morskim. Tu problem polega na tym, że prognozy przygotowywane są dla dużych obszarów, dla których właściwie należało by sporządzić kilka lub nawet kilkadziesiąt prognoz.

Teraz łatwiej nam będzie zrozumieć, dlaczego nawet dysponując znakomitymi apkami pogodowymi profesjonalne teamy regatowe często zatrudniają meteorologów. Najlepiej tak zwanego lokalesa. On najwięcej wie o tym, co się na niebie w danym miejscu dzieje.

Zresztą nawet te niesprawdzające się dzisiaj prognozy i tak są lepsze od sączonej przez radio na falach długich w latach 70-tych informacji, że „na Bałtyku Południowym wiatry północne do północno-wschodnich 2 do 6”. To faktycznie sprawdzało się zawsze…

![Pierwszy taki przypadek od lat! Rekin olbrzymi w Chorwacji [wideo] rekin w Chorwacji](https://nowezagle.pl/wp-content/uploads/2021/03/Rekin-4-1-100x100.jpg)